AI在当下对于视频&微动效的处理能力如何?是否已经达到了可以商用的程度?曾经试过一些AI视频工具但是体验不好,应该如何操作?不会AE、C4D但是我想做个动态效果怎么弄?

通过AI可以快速完成视频&动效设计,仅需要几分钟的时间就能完成传统需要拍摄或渲染等几个小时才能完成的工作,在短时间内提供有效的解决方案。

拍摄高质量镜头画面时,传统需要使用高清摄像设备,并且需要利用补光灯确保视频画面明亮而均匀,避免出现强烈的阴影区域。同时使用稳定器确保镜头稳定,避免抖动画面,还需要注重背景干净整洁,以突出主体…

但是对于AI的生成以上繁琐的工作,仅仅只是输入“提示词”即可获得以上所有结果。

对于未确定方案的设计,以往产出两版以上方案,至少需要守着电脑调整上几个小时,偶尔在遇上几个项目同时进行,将把大量时间耗费再方案初稿的制作上,这种情况却是不太划算,因此交给AI来处理会更轻松。

当然对于AI在视频及动效领域使用也不仅仅只局限于此。

将格局打开,对于AI拓展其更多还是进行是创意产生,结合不同有趣的内容来引起观众兴趣。

AI所产出的内容也更具多元化,形式丰富,风格广泛动漫、3D、日常、现代、电影、真实、国风…都很擅长。

近半个月的时间,对市面上常见的几款AI视频生成工具进行了体验尝试。

其中runway的可用性最高,产出效果最稳,能够通过运动笔刷手动控制运动范围,还有运镜、配色调整比较实用的功能,并且清晰度也强于其他工具。

但是runway在实际使用过程的体验,属于半免费模式,普通用户每月有数量限制,很可能刚刚生成了几个较为满意的画面后,继续在产出相似内容就需要付费。

其余还使用了Pika、stablevideo、whee这三个工具,但是感觉可用性还是略低了一些,总体来看距离使用AI在视频及动效领域商用还是有所不足。

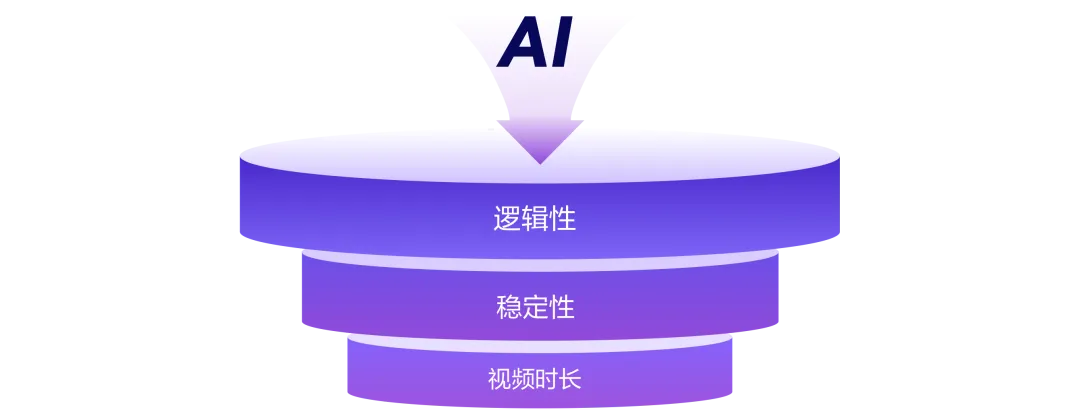

影响因素

经过短期体验后,主要发现以下三个主要因素,会影响AI生产视频及动效可用性的。

放任AI自由发挥时,会经常出现一些逻辑性错误,很多视频与动效都缺乏真实感,主要体现在与现实世界规律不同。例如:半静止半运动的效果,车辆在运动但车动不转,水流时水花在动水面确实静止的…..等种种不符合常理的效果。

对原始内容的视频及动效可控性低,尤其是以人物为主,即使“提示词”相同情况下,生成的内容也会出现较大的差异,以至于操作多次也无法得到一个满意的效果。

主流工具视频时长一般在3-4秒,而Sora内测公布的最长为30秒一个镜头。当然目前来看3-4秒的时间,仅适合用于分镜,想要用与制作视频的话还需要进行剪辑。

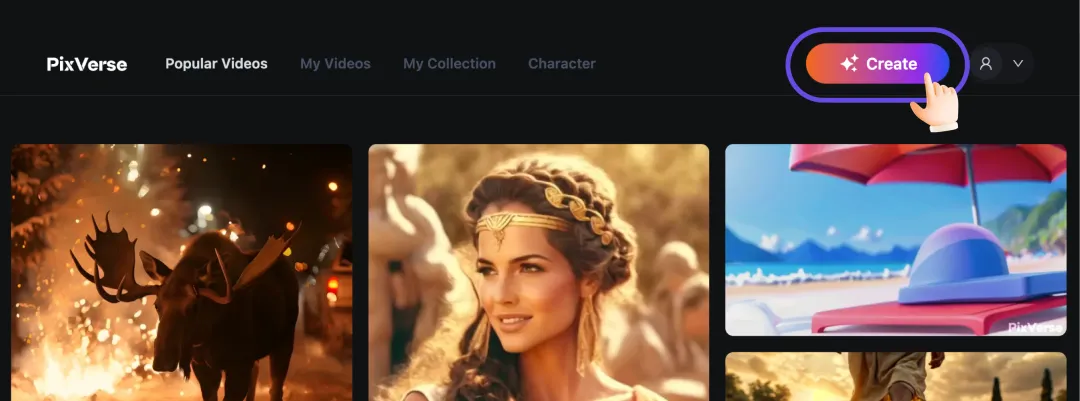

PixVerse是一款完全免费的AI微视频动效生成工具,对比runway的后续还需要付费的问题性价比确实是非常高的。

这款工具用户界面十分友好,操作比较便捷并且AI算法及AI模型也比较先进可以进行高质量的视频制作,也可以进行大分辨率的高清质量输出。

接下来简单介绍一下工具的基本功能,工具网址:https://app.pixverse.ai/

完成注册登录后,就可以使用创作功能了。点击页面的右上角即可进入。

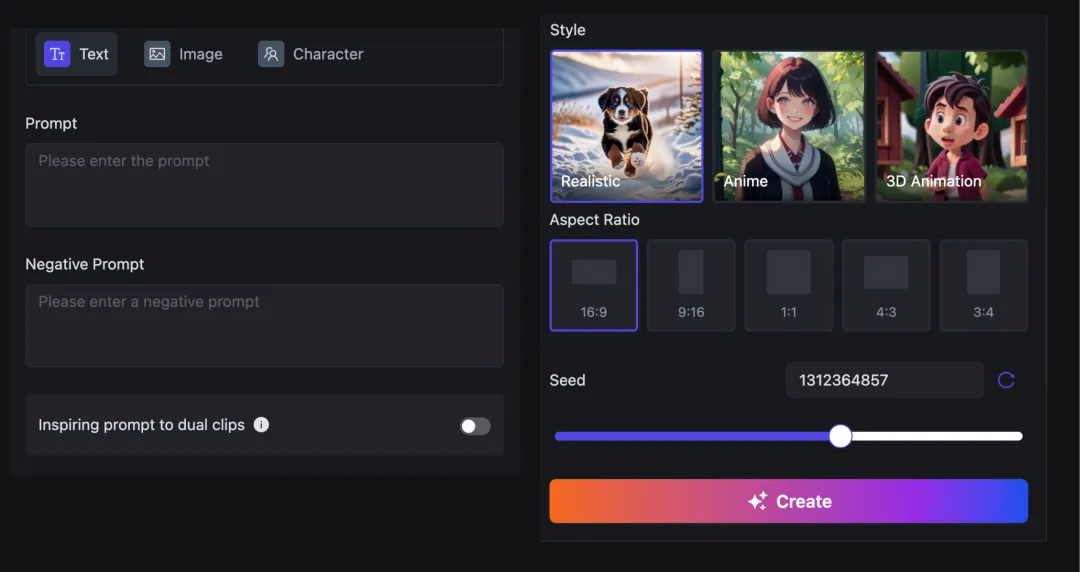

进入创作功能后可以看到第一排依次有三个主要功能:文本、图像、换脸。

文本生成

功能依次为1.输入正向提示词、2.输入反向提示词、3.一次连续生成两个视频、4.风格选择、5.视频比例、6.种子数

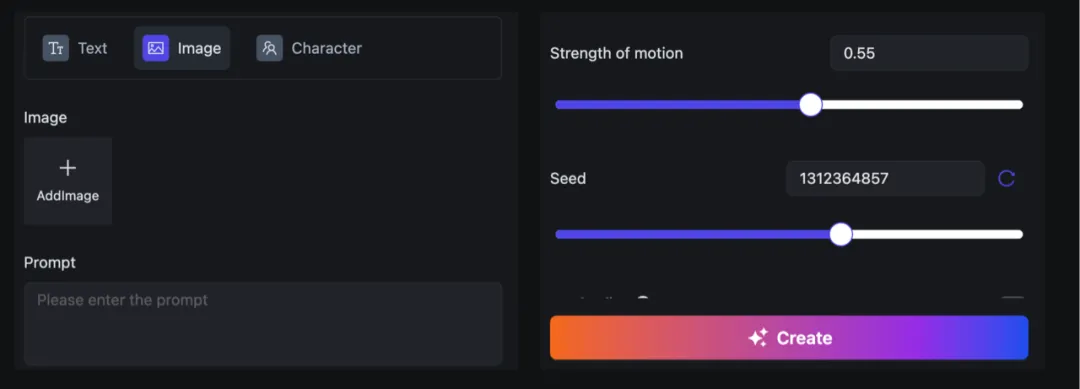

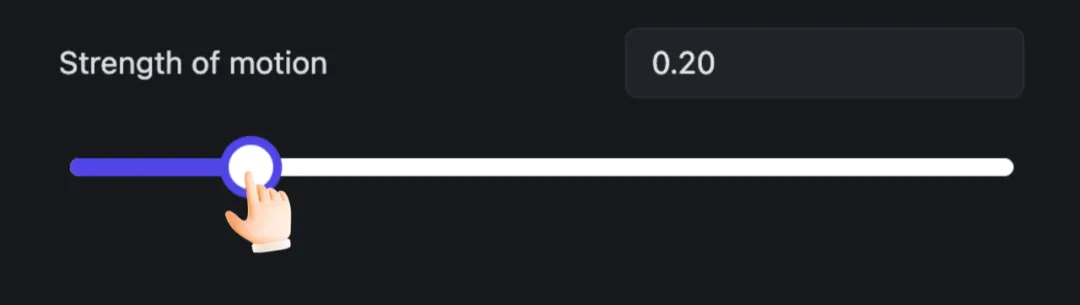

功能依次为1.上传/选择已有图片、2.输入正向提示词、3.运动强度(重点)、4.种子数、5.高清画质(重点)

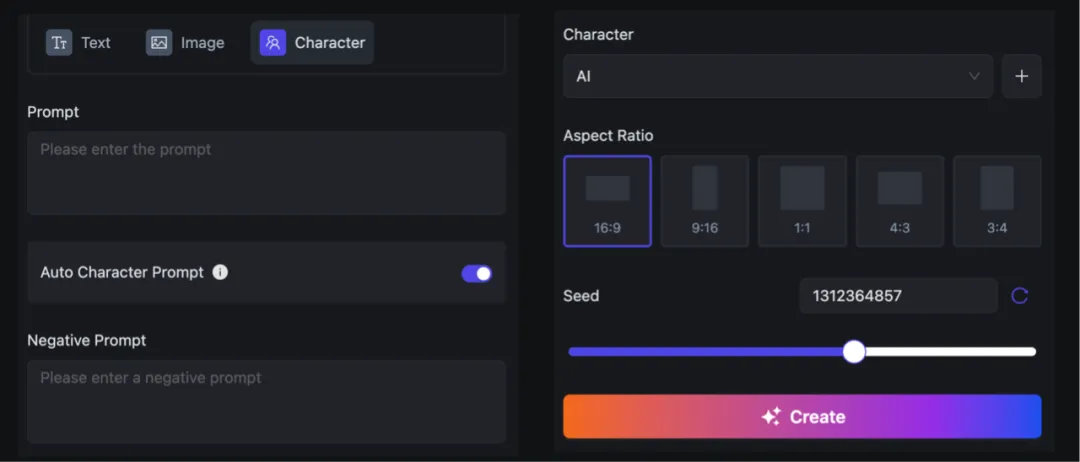

这个工具的换脸与常用的图片换脸还是略有区别,主要是使用获取到的人物特点与提示词进行重绘。

功能依次为1.输入正向提示词、2.色彩增强、3.输入反向提示词、4.添加人物(重点)5.视频比例、6.种子数。

除生成视频以外还有视频广场、我的视频、我的收藏及人脸特点记录等其他功能。

初次使用你一定会感觉这个工具很傻BUG太多了,感觉并不是很稳定可用性没那么高。是的你感觉没有问题,这个工具确实需要控制才能输出靠谱的视频动效。

这是一个AI视频动效工具,而不是一个AI图像工具,因此请放弃使用文生图的想法吧!这个功能真的很鸡肋!

对比可以看一下,上面是PixVerse生成下面是Midjourney生成,视觉效果清晰度等差距真的很大。

建议一:通过Midjourney、Stable Diffusion等平台生成图像内容后在导入PixVerse进行视频动效处理,不要使用PixVerse自带的文生图功能

PixVerse对于图像生成视频动效,会根据原图尺寸进行输出,因此需要在上传图像时调整好所需视频的尺寸比例等,节省后期对视频二次加工剪辑的成本。

当然越大尺寸的图像生成时的速度也会变慢,但稍稍的等待还是值得的。

同时打开高清画质,虽然速度会稍慢些,但是输出视频动效的可用程度更好。当然在快速实验草稿时还是可以关闭的。

翻白眼、四肢麻花状扭曲、凭空出现异物、五官挤压变形、局部模糊使用过AI视频动效工具的一定会深有体会,这种画面崩坏经常是无缘无故的出现几乎没什么办法进行控制。

因此为了避免画面崩坏的情况发生,首先建议对运动强度进行调节,由0.01逐渐向上增加直至1.00为止。

建议四:初期的运动强度建议使用0.20-0.40之间为宜,后期可根据生成效果逐渐调高或降低。

种子值也不要忘记使用哦!Seed种子数是用来标记图片的编号,使用相同的 Seed 值能够产生相似的视频动效。可以通过在热门视频广场中找寻一些适合的效果,然后粘贴上他的 Seed 值,这样生成的结果也能很好避免了画面崩坏的几率。

上面是热门广场中的视频,使用上他的Seed 值后我的图像也获得相似的眨眼效果。

建议五:如果发现有合适的视频动效,记得复制他的种子值用在所生的图像中也能获得相似的效果。

当然做为UI设计师,对于视频需求并不是那么多,日常工作中还是主要已产品动效为主,因此通过PixVerse解决一些手上实际的需求,更能体现其实用性。

对于一些场景类的提示ICON动效,可以直接交给AI来做,使用PixVerse可一次性获得四版方案,即使不满意也没有任何限制,持续生成就可以了直到满意为止。

日常工作中运营浮窗的动效设计也是必不可少的,此类偏运营的需求会占用掉大量的精力,主要在图片的分层导出及AE等软件的制作中,即便有一些动效插件,也需要对设计稿的图层进行分组。对此使用AI搞定动效的方式,是快速批量解决此类简单动效需求的一个出路。

上面为AE制作,下面为AI制作(当然AI做的还是有些小问题的,主要不是透明背景)

此类ICON精度要求比较之前两个更高,如果使用AI工具可用性并不大,即使视觉能用,转为json的文件也会过大。因此更适合用与动效的概念设定。

例如针对首页的小房子ICON,AI会提供一些动效以便参考,放大缩小,线性变形,颜色变化等方案

经过这半个月的体验后也逐渐有了一些粗浅的认识,虽然没有预想的那么好用,但是也没有特别不适的体验。其主要原因还是由于图像AI工具已经成熟,使用Midjourney等工具能够完全可以帮助设计落地。随着算法模型等不断的迭代,预计下半年AI对于视频动效领域会出现一些质的飞跃。

当然例如PixVerse等类型的AI工具还有许多,期待各位的探索。