ChatGPT横空出世之后,大语言模型已成为我们获取信息、解答疑问的得力助手。但当面对复杂多变的问题时,单纯的直接询问往往难以让模型给出期待的答案。这时,精心设计的提示词(prompt)就显得至关重要——这正是prompt engineering的艺术所在。今天,我们将一起深入大语言模型的世界,探索如何巧妙构建prompt,引导它为我们提供更精准、更有趣、更有价值的信息!

Part 1 零样本提示

提示:

将文本分类为中性、负面或正面。

文本:我认为这次假期还可以。

情感:

输出:

中性

Part 2 少样本提示

提示:

A “whatpu” is a small, furry animal native to Tanzania. An example of a sentence that usesthe word whatpu is:We were traveling in Africa and we saw these very cute whatpus.To do a “farduddle” means to jump up and down really fast. An example of a sentence that usesthe word farduddle is:

输出:

One day when I was playing tag with my little sister, she got really excited and shestarted doing these crazy farduddles.

-

-

标签空间和演示指定的输入文本的分布都很重要(无论标签是否对单个输入正确) -

使用的格式也对性能起着关键作用,即使只是使用随机标签,这也比没有标签好得多。 -

其他结果表明,从真实标签分布(而不是均匀分布)中选择随机标签也有帮助。

-

提示:

这太棒了!// Negative

这太糟糕了!// Positive

哇,那部电影太棒了!// Positive

多么可怕的节目!//

输出:

Negative

提示:

Positive This is awesome!

This is bad! Negative

Wow that movie was rad!

Positive

What a horrible show! —

输出:

Negative

提示:

-

-

-

这组数字中的奇数加起来是一个偶数:15、32、5、13、82、7、1。

-

A:

-

-

输出:

是的,这组数字中的奇数加起来是107,是一个偶数。

提示:

-

-

-

这组数字中的奇数加起来是一个偶数:4、8、9、15、12、2、1。

-

A:答案是False。

-

这组数字中的奇数加起来是一个偶数:17、10、19、4、8、12、24。

-

A:答案是True。

-

这组数字中的奇数加起来是一个偶数:16、11、14、4、8、13、24。

-

A:答案是True。

-

这组数字中的奇数加起来是一个偶数:17、9、10、12、13、4、2。

-

A:答案是False。

-

这组数字中的奇数加起来是一个偶数:15、32、5、13、82、7、1。

-

A:

-

-

输出:

答案是True。

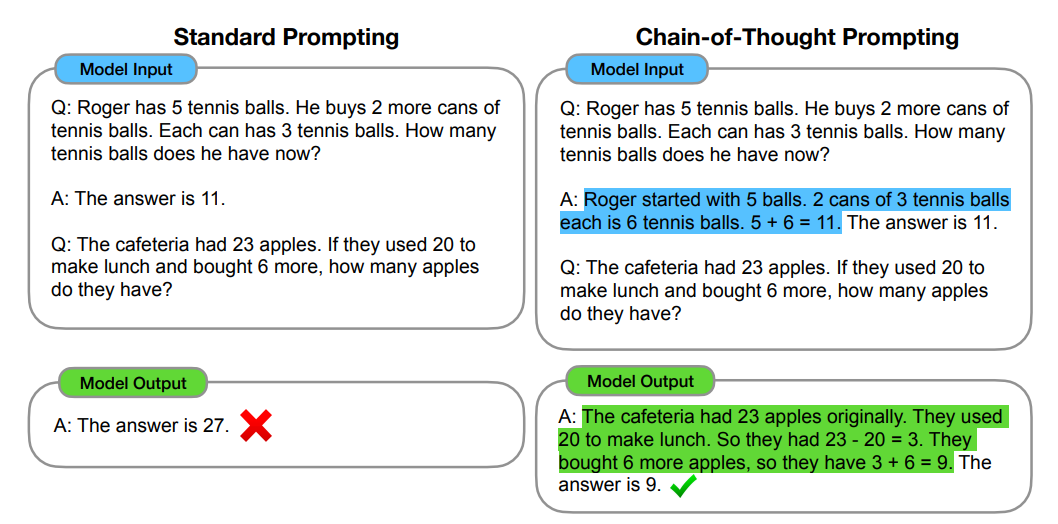

Part 3 链式思考(CoT)提示

提示:

-

-

-

这组数中的奇数加起来是偶数:4、8、9、15、12、2、1。

-

A:将所有奇数相加(9、15、1)得到25。答案为False。

-

这组数中的奇数加起来是偶数:17、10、19、4、8、12、24。

-

A:将所有奇数相加(17、19)得到36。答案为True。

-

这组数中的奇数加起来是偶数:16、11、14、4、8、13、24。

-

A:将所有奇数相加(11、13)得到24。答案为True。

-

这组数中的奇数加起来是偶数:17、9、10、12、13、4、2。

-

A:将所有奇数相加(17、9、13)得到39。答案为False。

-

这组数中的奇数加起来是偶数:15、32、5、13、82、7、1。

-

A:

-

-

输出:

将所有奇数相加(15、5、13、7、1)得到41。答案为False。

提示:

-

-

-

这组数中的奇数加起来是偶数:4、8、9、15、12、2、1。

-

A:将所有奇数相加(9、15、1)得到25。答案为False。

-

这组数中的奇数加起来是偶数:15、32、5、13、82、7、1。

-

A:

-

-

输出:

将所有奇数相加(15、5、13、7、1)得到41。答案为False。

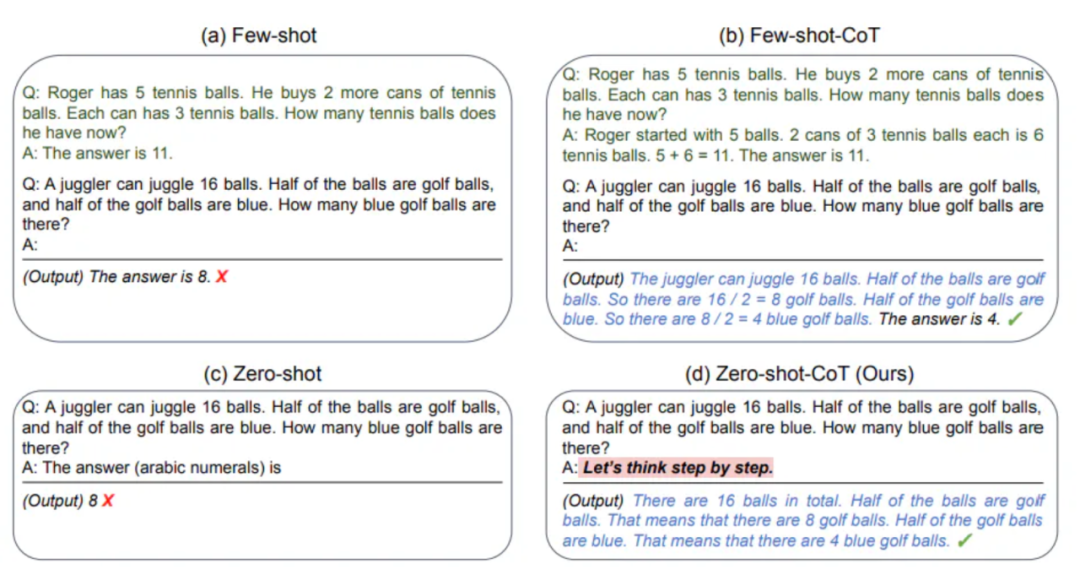

Part 4 零样本COT提示

提示:

我去市场买了10个苹果。我给了邻居2个苹果和修理工2个苹果。然后我去买了5个苹果并吃了1个。我还剩下多少苹果?

输出:

11个苹果。

提示:

我去市场买了10个苹果。我给了邻居2个苹果和修理工2个苹果。然后我去买了5个苹果并吃了1个。我还剩下多少苹果?

让我们逐步思考。

输出:

首先,您从10个苹果开始。

您给了邻居和修理工各2个苹果,所以您还剩下6个苹果。

然后您买了5个苹果,所以现在您有11个苹果。

最后,您吃了1个苹果,所以您还剩下10个苹果。

Part 4 小结