?Sora将于今年内公开发布

?腾讯联合清华、港科大推出图生视频大模型“Follow Your Click”

?清华&阿里合作推出“概念半透膜”模型

?谷歌发布SIMA模型

1、Sora将于今年内公开发布,未来将支持为视频添加声音

多知网3月15日消息,OpenAI首席技术官Mira Murati透露,Sora计划在今年向公众发布,目前,OpenAI一直在不断打磨并进行外部测试,尤其关注电影行业的创作者。Mira Murati表示,目前尚未确认公开发布时间,可能需要几个月。

据了解,OpenAI团队还在不断优化资源,以确保生成过程更加高效。Sora针对720P分辨率或20秒的长视频,生成时间大约只需几分钟,速度令人惊叹。

除此之外,Murati还透露,虽然目前的视频生成还不支持声音 ,但未来将支持音效配备功能,这意味着用户可以为生成的视频添加声音。此外,Sora还将允许用户对生成的视频内容进行编辑,这为用户提供了更大的自由度和创意空间。

随着产品的正式发布,Sora将吸引更广泛的用户群体,为他们带来全新的创作体验。(多知 Doris)

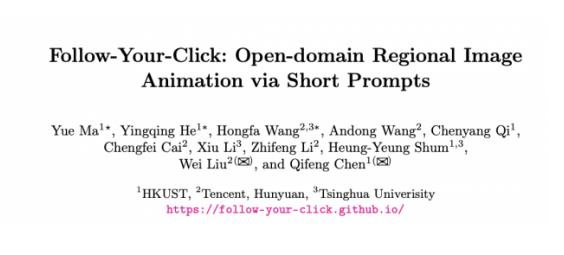

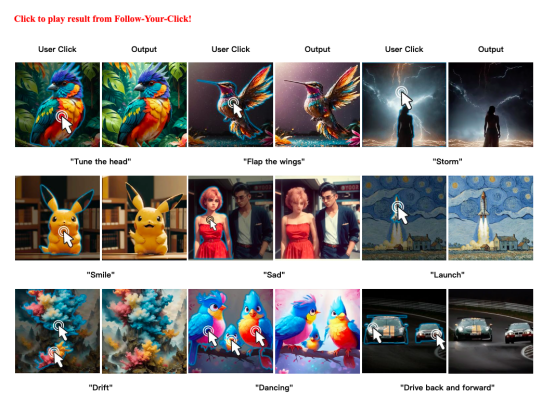

2、腾讯联合清华、港科大推出图生视频大模型“Follow Your Click”:一键点,万物动?

多知网3月15日消息,腾讯联合清华、港科大推出全新图生视频模型“Follow-Your-Click”,目前已经上架 GitHub(代码四月公开),同时还发表了一篇研究论文。

这款图生视频模型主要功能包括局部动画生成和多对象动画,支持多种动作表达,如头部调整、翅膀拍动等。

Follow-Your-Click 可以通过用户的点击和简短动作提示生成局部图像动画。

用户只需点击对应区域,加上少量提示词,就可以让图片中原本静态的区域动起来,一键转换成视频,比如让物体微笑、跳舞或飘动。

除了能够控制单个对象的动画,这个框架还支持同时对多个对象进行动画处理,增加了动画的复杂性和丰富性。用户可以通过简单的点击和短语提示轻松地指定希望动画化的区域和动作类型,无需复杂的操作或详细描述。

这款模型在带来更加便捷的交互同时,也让图片“一键点,万物动”成为现实。

当前图生视频大模型中,一般的生成方法不仅需要用户在提示词中描述运动区域,还需要提供运动指令的详细描述,过程较为复杂。从生成的效果来看,现有图像生成视频技术在移动图像的指定部分上缺乏控制,生成的视频往往需要移动整个场景,而不是图像上的某一个区域,精准度和灵活性上有所欠缺。

另附:

论文链接:[2403.08268] Follow-Your-Click: Open-domain Regional Image Animation via Short Prompts

主页:Follow-Your-Click

Github:GitHub – mayuelala/FollowYourClick: [arXiv 2024] Follow-Your-Click: This repo is the official implementation of “Follow-Your-Click: Open-domain Regional Image Animation via Short Prompts”

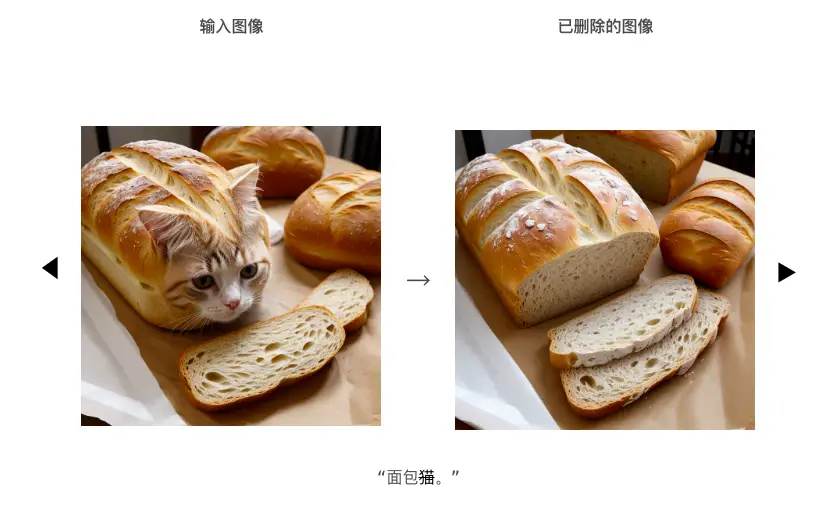

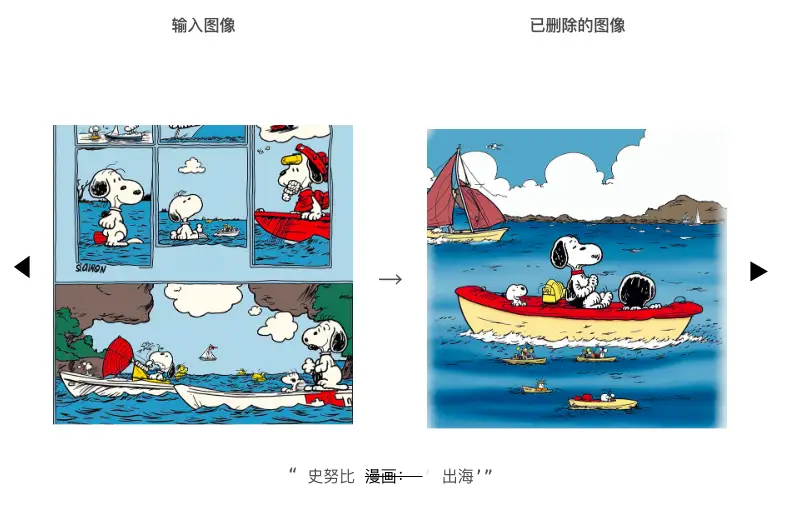

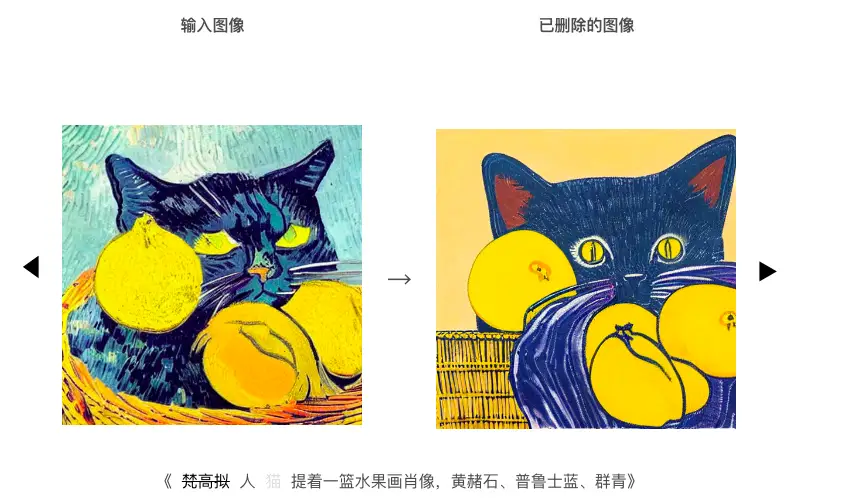

3、一键擦除:清华&阿里合作推出“概念半透膜”模型

多知网3月14日消息,清华大学丁贵广教授团队和阿里安全联合发布了概念半透膜模型(concept Semi-Permeable Membrane,SPM 模型),该模型能够在 Diffusion 架构的 AI 作图模型中,精准、可控地擦除各类具象或抽象概念,并对无关概念做到几乎完全保留。

相关论文《One-dimensional Adapter to Rule Them All: Concepts, Diffusion Models and Erasing Applications》已经被计算机视觉国际顶级会议 CVPR 2024 高分录用。

阿里集团资深总监、人工智能治理与可持续发展研究中心主任、集团科技伦理治理委员会执行主席薛晖表示:该项成果在通义大模型系列的 AIGC 内生安全领域、可控生成等方面都具备落地潜力,能够有效避免有害概念的侵害,促进通义等 AI 技术产品可用、可靠、可信、可控地向善发展。(多知 Mint)

另附:

项目主页:https://lyumengyao.github.io/projects/spm

Github 地址:https://github.com/Con6924/SPM

论文地址:https://arxiv.org/abs/2312.16145

4、谷歌发布SIMA模型,你期待游戏中的“神队友”吗?

多知网3月15日消息,谷歌DeepMind团队发布了一款名为SIMA的模型,能通过训练和学习游戏技能,使其操作风格更加贴近人类。SIMA,全称“Scalable, Instructable, Multiworld Agent”(可扩展、可指导、多世界Agent),目前虽处于研究阶段,但未来有望成为玩家们的得力助手。

SIMA通过收集大量的人类玩家游戏数据来训练,这些数据包括视频、语言指令、动作记录和成功与否的标记。它使用深度学习模型来学习如何将视觉观察(即游戏画面)和语言指令映射到键盘和鼠标动作上。这个过程中,它还会使用预训练的模型来帮助理解和处理视觉信息,以及通过所谓的“无分类器引导”(Classifier-Free Guidance)技术来增强语言指令的条件性。

SIMA的定位并非传统意义上的游戏AI NPC,而是致力于成为玩家的默契队友,能够实时配合玩家的操作。为了实现这一目标,SIMA结合了自然语言和图像识别技术,使其能够深入理解3D游戏世界。通过与玩家的互动,SIMA能够逐步掌握游戏的规则和策略,从而更加精准地执行任务。

未来,随着SIMA技能的不断提升和拓展,它有望成为玩家们的得力助手和“神队友”。无论是在单人游戏中协助完成任务,还是在多人游戏中提供战略支持,SIMA都将展现出强大的潜力和价值。(多知 Doris)